Natural Language Understanding (NLU)

Natural Language Understanding é um serviço do Watson, uma API REST, que utiliza o modelo customizado de machine learning treinado no Knowledge Studio para classificar e identificar as novas entidades provenientes deste modelo e retornar ao usuário o resultado do texto processado e analisado.

Instanciando Serviço

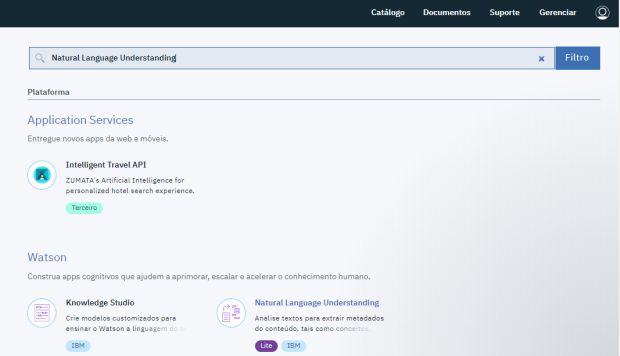

Logado no IBM Cloud, busque no catálogo por Natural Language Understanding. Clique no link dele.

Agora, assim como o Knowledge Studio, para instanciar o Natural Language Understanding (NLU), verifique a região de implementação, organização (seu e-mail) e o espaço. Com tudo certo, clique em ‘Criar’.

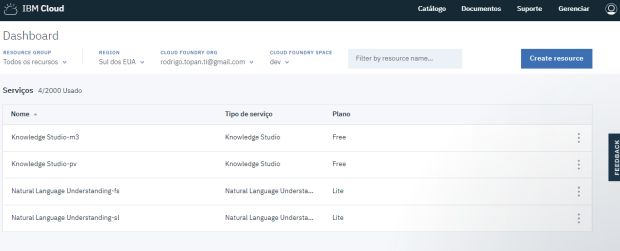

Com o NLU instanciado, você será redirecionado ao painel de gerenciamento. Repare no nome acima, você terá algo como ‘Natural Language Understanding-sl’, esse é o nome da sua instância que mais tarde você irá relacionar ao seu modelo de machine learning do Knowledge Studio.

Criar Credencial de Acesso

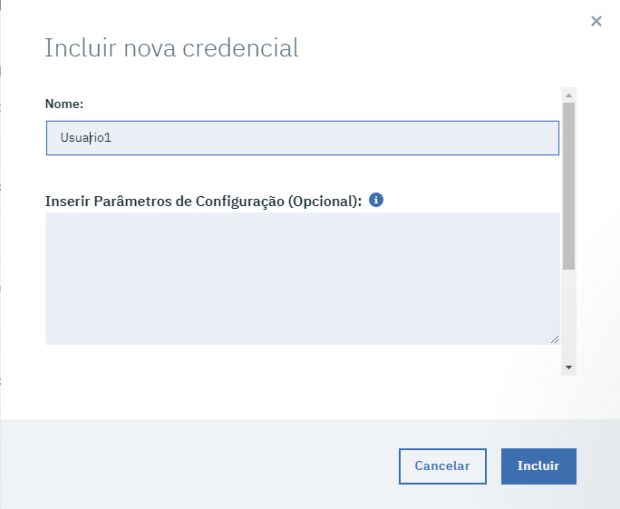

Devemos criar uma credencial de acesso ao serviço da NLU para realizar requisições e receber respostas deste serviço. Clique em ‘Nova credencial’.

Escolha o nome de preferência da credencial(chave) de acesso e clique em ‘Incluir’.

Repare que agora a plataforma já criou a sua credencial de acesso ao serviço da NLU. Se você clicar em ‘Visualizar credenciais’, a plataforma te apresentará o seu username, sua password e a url do endpoint do serviço (você poderá realizar requisições, enviando textos a esse endpoint e obter os resultados do processamento deste).

Todas estas credenciais foram geradas automaticamente em forma de token especificamente para a chave ‘Usuario1’ no meu caso de exemplo. Guarde essas credenciais, pois agora iremos relacionar nosso modelo de machine learning treinado na primeira parte desta série de artigos.

Credenciais da chave especificada em formato JSON.

Apontar o seu modelo customizado, criado no Knowledge Studio para a NLU

De volta ao dashboard, repare que possuo diferentes instâncias dos mesmos serviços. Devemos buscar a instância que possui o nosso workspace que possui o nosso modelo treinado, o qual iremos relacionar ao NLU. No meu caso, minha instância se chama Knowledge Studio-pv. Clique na sua instância.

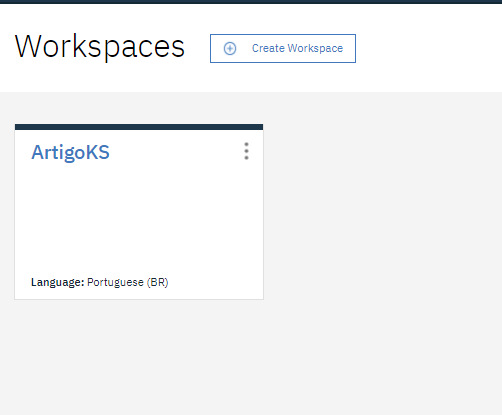

Clicando em Launch, acessaremos o painel da nossa instância do Knowledge Studio. Lá, deve estar a nossa workspace do nosso modelo treinado. Abra a workspace. No meu caso, ela se chama ‘ArtigoKS’.

Voltamos ao ponto final da parte 01 do artigo. No menu lateral, em Model Management, clique em versions.

Nessa interface, possuímos o controle da versão dos nossos modelos. Vamos publicar nosso modelo agora através do botão ‘deploy’, na segunda linha da tabela, coluna ‘Action’.

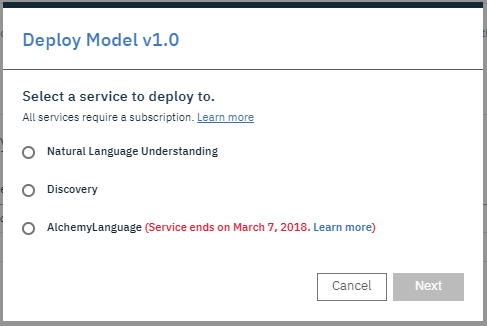

Selecione Natural Language Understanding e clique em next para fazermos o relacionamento com o nosso serviço da NLU.

Verifique a região de implementação, o espaço de desenvolvimento do IBM Cloud, e repare atentamente agora nas opções de ‘Service instance’. Selecione a instância do seu Natural Language Understanding que foi criado durante o processo deste artigo. Cuidado para não confundir com outras eventuais instâncias. Ou seja, para mim, devo escolher o Natural Language Understanding-sl. Clique em deploy.

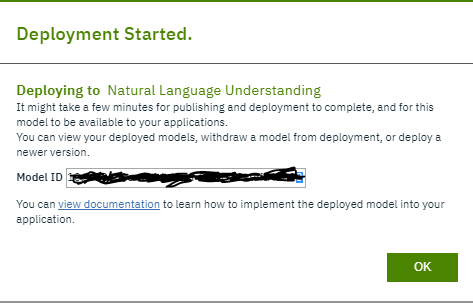

Ao realizar esse processo, a plataforma irá gerar um ‘Model Id’ para acesso ao seu modelo. Esse model id é a identificação do seu modelo treinado e não deve ser divulgado, juntamente com as suas credenciais de acesso. Guarde-o com muito cuidado.

Nós então possuímos nosso modelo de machine learning treinado através do Watson Knowledge Studio, relacionado ao nosso serviço REST, Natural Language Understanding, credenciais de acesso e um endpoint para realizarmos nossas requisições e obtermos respostas e retornos. Na parte 03 deste artigo, ensinarei como realizar essas requisições e utilizar a documentação ‘Swagger’, disponibilizada pelo Watson Api Explorer.