Anunciando o ajuste fino do Phi-3, novos modelos de IA generativa e outras atualizações do Azure AI

Atualizações tem como objetivo capacitar as organizações a customizar e dimensionar aplicativos de IA

Por Asha Sharma, vice-presidente corporativa da AI Platform

A IA está transformando todos os setores e criando oportunidades de inovação e crescimento. Mas, desenvolver e implantar aplicativos de IA em escala requer uma plataforma robusta e flexível, capaz de lidar com as necessidades complexas e diversas das empresas modernas e de permitir a elas criarem soluções baseadas em seus dados organizacionais. É por isso que temos o prazer de anunciar várias atualizações para ajudar os desenvolvedores a criarem rapidamente soluções de IA personalizadas com mais opções de escolha e maior flexibilidade, aproveitando a cadeia de ferramentas de IA do Azure:

- O ajuste fino sem servidor para modelos Phi-3-mini e Phi-3-medium permite aos desenvolvedores personalizarem os modelos de forma rápida e fácil para cenários de nuvem e borda, sem precisar organizar a computação.

- Atualizações para o Phi-3-mini, incluindo melhoria significativa na qualidade do núcleo, acompanhamento de instruções e saída estruturada, permitindo que os desenvolvedores criem com um modelo de melhor desempenho sem custo adicional.

- Distribuição imediata no início deste mês dos modelos mais recentes da OpenAI (GPT-4o mini), Meta (Llama 3.1 405B), Mistral (Large 2) para o Azure AI e com isso oferecer aos clientes mais opções de escolha e maior flexibilidade. A novidade de hoje é o Cohere Rerank.

Phi-3 – Desbloqueando valor por meio da inovação e personalização de modelos

Em abril, apresentamos a família Phi-3 de pequenos modelos de linguagem abertos, desenvolvidos pela Microsoft. Phi-3 são nossos pequenos modelos de linguagem (SLMs), os mais capazes e econômicos disponíveis. À medida que os desenvolvedores procuram adaptar as soluções de IA para atender necessidades específicas dos negócios e melhorar a qualidade das respostas, o ajuste fino de um pequeno modelo de linguagem é uma ótima alternativa, pois não afeta o desempenho. A partir de hoje, os desenvolvedores podem ajustar o Phi-3-mini e o Phi-3-medium com seus dados para criar experiências de IA mais relevantes aos usuários, com segurança e economia.

Dada a sua pequena pegada de computação, compatibilidade com nuvem e borda, os modelos Phi-3 são adequados para ajuste fino o que melhora o desempenho do modelo básico em uma variedade de cenários, incluindo o aprendizado de uma nova habilidade ou tarefa (por exemplo, tutoria) ou o aprimoramento da consistência e qualidade da resposta (por exemplo, tom ou estilo de respostas no bate-papo/perguntas e respostas). Já estamos vendo adaptações do Phi-3 para novos casos de uso.

A Microsoft e a Khan Academy estão trabalhando juntas para melhorar suas soluções para professores e alunos em todo o mundo. Como parte da colaboração, a Khan Academy usa o Azure OpenAI Service para alimentar o “Khanmigo for Teachers”, um projeto piloto de assistente de ensino com inteligência artificial criado para atender educadores em 44 países e está, agora, experimentando o Phi-3 para melhorar o ensino de matemática. A Khan Academy publicou recentemente um artigo de pesquisa destacando o desempenho de diferentes modelos de IA ao avaliar a precisão matemática em cenários de tutoria, incluindo benchmarks de uma versão ajustada do Phi-3. Os dados iniciais mostram que, quando um aluno comete um erro matemático, o Phi-3 superou a maioria dos outros modelos líderes de IA generativa na correção e identificação desses erros .

Também ajustamos o Phi-3 para dispositivo. Em junho, apresentamos o Phi Silica para capacitar os desenvolvedores com um modelo poderoso e confiável para criar aplicativos com experiências de IA seguras e protegidas. O Phi Silica se baseia na família de modelos Phi e foi projetado especificamente para as NPUs em PCs Copilot+. O Microsoft Windows é a primeira plataforma a ter um pequeno modelo de linguagem (SLM) de última geração personalizado para a Unidade de Processamento Neural (NPU) e a caixa de entrada de remessa.

Você pode testar hoje o ajuste fino para modelos Phi-3 no Azure AI.

Também estou animada em compartilhar que nosso recurso de ‘Modelos como serviço” – Model-as-a-Service, em inglês – (endpoint sem servidor) no Azure AI está disponível. Já o Phi-3-small está à disposição por meio de um endpoint sem servidor. Dessa forma, os desenvolvedores podem começar a desenvolver IA de maneira rápida e fácil, sem precisar gerenciar a infraestrutura subjacente. O Phi-3-vision, modelo multimodal da família Phi-3, foi anunciado no Microsoft Build e está disponível no catálogo de modelos de IA do Azure. Em breve, ele estará disponível por meio de um endpoint sem servidor. O Phi-3-small (parâmetro 7B) está liberado em dois comprimentos de contexto: 128K e 8K, enquanto o Phi-3-vision (parâmetro 4.2B) foi otimizado para compreensão de gráficos e diagramas, podendo assim ser usado para gerar insights e responder perguntas.

Estamos observando uma ótima resposta da comunidade em Phi-3. Lançamos uma atualização para o Phi-3-mini no mês passado, que trouxe uma melhoria significativa na qualidade do núcleo e nas instruções seguintes. O modelo foi treinado novamente, o que levou a uma melhoria substancial no acompanhamento de instruções e suporte para resultados estruturados. Além disso, melhoramos a qualidade da conversa em vários turnos, introduzimos suporte para prompts <|system|> e melhoramos significativamente a capacidade de raciocínio.

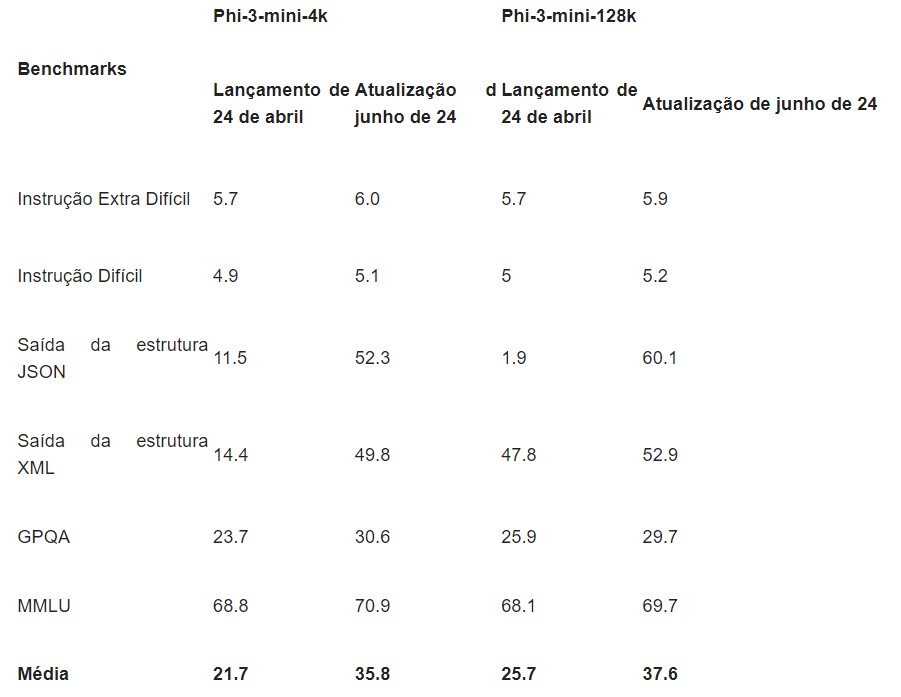

A tabela abaixo destaca as melhorias no acompanhamento de instruções, na saída estruturada e no raciocínio.

Continuamos a fazer melhorias na segurança do Phi-3 também. Um artigo de pesquisa recente destacou a abordagem interativa de “Quebra e conserto” da Microsoft para melhorar a segurança dos modelos Phi-3, que envolveu várias rodadas de testes e refinamento, red team e identificação de vulnerabilidades. Esse método reduziu significativamente o conteúdo nocivo em 75% e melhorou o desempenho dos modelos em benchmarks de IA responsável.

Expandindo a escolha de modelos, agora com mais de 1600 opções disponíveis no Azure AI

Com a IA do Azure, estamos comprometidos em trazer a seleção mais abrangente de modelos abertos e de fronteira e ferramentas de última geração para ajudar a atender às necessidades exclusivas de custo, latência e design dos clientes. No ano passado, lançamos o catálogo de modelos do Azure AI, onde agora temos a mais ampla seleção, com mais de 1.600 modelos de provedores, incluindo AI21, Cohere, Databricks, Hugging Face, Meta, Mistral, Microsoft Research, OpenAI, Snowflake, Stability AI e outros. Este mês, adicionamos o GPT-4o mini da OpenAI por meio do Azure OpenAI Service, Meta Llama 3.1 405B e Mistral Large 2.

Hoje temos o prazer de compartilhar que o Cohere Rerank agora está disponível no Azure. O acesso aos modelos de linguagem prontos para empresas da Cohere na infraestrutura robusta do Azure AI permite que as empresas incorporem de forma contínua, confiável e segura a tecnologia de pesquisa semântica de ponta em seus aplicativos. Essa integração permite que os usuários aproveitem a flexibilidade e a escalabilidade do Azure, combinadas com os modelos de linguagem eficientes e de alto desempenho da Cohere, para fornecer resultados de pesquisa superiores na produção.

O TD Bank Group, um dos maiores bancos da América do Norte, assinou recentemente um acordo com a Cohere para explorar seu conjunto completo de grandes modelos de linguagem (LLMs), incluindo o Cohere Rerank.

Kirsti Racine, vice-presidente líder de tecnologia de IA no TD.

No TD, vimos o potencial transformador da IA para oferecer experiências mais personalizadas e intuitivas para nossos clientes, colegas e comunidades. Estamos entusiasmados em trabalhar ao lado da Cohere para explorar o desempenho de seus modelos de linguagem no Microsoft Azure para ajudar a apoiar nossa jornada de inovação no Banco.”

A Atomicwork, uma plataforma de workplace digital e cliente de longa data do Azure, aprimorou significativamente sua plataforma de gerenciamento de serviços de TI com o Cohere Rerank. Ao integrar o modelo em seu assistente digital de IA, Atom AI, a Atomicwork melhorou a precisão e a relevância da pesquisa, fornecendo respostas mais rápidas e precisas para consultas complexas de suporte de TI. Essa integração simplificou as operações de TI e aumentou a produtividade em toda a empresa.

Vijay Rayapati, CEO da Atomicwork

A força motriz por trás da solução de experiência digital no workplace da Atomicwork é o modelo Rerank da Cohere e o Azure AI Studio, que capacita o Atom AI, nosso assistente digital, com a precisão e o desempenho necessários para fornecer resultados do mundo real. Essa colaboração estratégica ressalta nosso compromisso em fornecer às empresas recursos avançados de IA empresarial

O Command R+, o principal modelo generativo da Cohere, que também está disponível no Azure AI, foi desenvolvido especificamente para funcionar bem com o Cohere Rerank em um sistema RAG (Geração Aumentada de Recuperação). Juntos, eles são capazes de atender a algumas das cargas de trabalho corporativas mais exigentes em produção.

No início desta semana, anunciamos que o Meta Llama 3.1 405B, juntamente com os modelos Llama 3.1 mais recentes e ajustados, incluindo 8B e 70B, agora estão disponíveis por meio de um endpoint sem servidor no Azure AI. O Llama 3.1 405B pode ser usado para geração e destilação de dados sintéticos avançados, com o 405B-Instruct servindo como um ‘modelo professor’ e os modelos 8B-Instruct / 70B-Instruct atuando como modelos alunos. Saiba mais sobre este anúncio aqui.

O Mistral Large 2 agora está disponível no Azure, tornando-nos o primeiro provedor de nuvem líder a oferecer esse modelo de última geração. O Mistral Large 2 supera as versões anteriores em codificação, raciocínio e comportamento agente, mantendo-se no mesmo nível de outros modelos líderes. Além disso, o Mistral Nemo, desenvolvido em colaboração com a NVIDIA, traz um poderoso modelo 12B que ultrapassa os limites da compreensão e geração de linguagem. Saiba mais.

E na semana passada, trouxemos o GPT-4o mini para o Azure AI junto com outras atualizações do Azure OpenAI Service, permitindo que os clientes expandam sua gama de aplicativos de IA a um custo e latência mais baixos com opções aprimoradas de segurança e implantação de dados. Anunciaremos mais recursos para GPT-4o mini nas próximas semanas. Também estamos felizes em apresentar um novo recurso para implantar chatbots criados com o Azure OpenAI Service no Microsoft Teams.

Habilitando a inovação de IA com segurança e responsabilidade

A criação de soluções de IA responsável está no centro do desenvolvimento de IA na Microsoft. Temos um conjunto robusto de recursos para ajudar as organizações a medir, mitigar e gerenciar os riscos em todo o ciclo de vida de desenvolvimento de IA para aplicativos tradicionais de aprendizado de máquina e IA generativa. As avaliações do Azure AI permitem que os desenvolvedores avaliem interativamente a qualidade e a segurança de modelos e aplicativos usando métricas internas e personalizadas para informar as mitigações. Recursos adicionais de Segurança de Conteúdo de IA do Azure, incluindo escudos de prompt e detecção de material protegido, agora estão “ativados por padrão” no Azure Open AI Service. Esses recursos podem ser aproveitados como filtros de conteúdo com qualquer modelo de base incluído em nosso catálogo de modelos, incluindo Phi-3, Lhama e Mistral. Os desenvolvedores também podem integrar esses recursos em seus aplicativos facilmente por meio de uma única API. Uma vez em produção, os desenvolvedores podem monitorar seu aplicativo quanto à qualidade e segurança, ataques de prompt adversários e integridade de dados, fazendo intervenções oportunas com a ajuda de alertas em tempo real.

O Azure AI usa o HiddenLayer Model Scanner para verificar modelos abertos e de terceiros em busca de ameaças emergentes, como vulnerabilidades de segurança cibernética, malware e outros sinais de violação, antes de integrá-los ao catálogo de modelos do Azure AI. As verificações resultantes do Model Scanner, fornecidas em cada cartão de modelo, podem dar às equipes de desenvolvedores maior confiança à medida que selecionam, ajustam e implantam modelos abertos para seu aplicativo.

Continuamos a investir em toda a pilha de IA do Azure para trazer inovação de última geração aos nossos clientes, para que você possa criar, implantar e dimensionar suas soluções de IA com segurança e confiança. Mal podemos esperar para ver o que você criará a seguir.

Mantenha-se atualizado com mais notícias do Azure AI

- Assista a este vídeo para saber mais sobre o catálogo de modelos de IA do Azure.

- Ouça o podcast sobre Phi-3 com o pesquisador principal da Microsoft, Sebastien Bubeck.